Datensicherheit in RAG-Applikationen mit Azure OpenAI - Ein Überblick

In der Welt der künstlichen Intelligenz (KI) nehmen datengesteuerte Anwendungen einen immer wichtigeren Platz ein. Besonders im Bereich von RAG-Applikationen (Retrieval Augmented Generation) und der Nutzung von Azure OpenAI gewinnen Fragen der Datensicherheit zunehmend an Bedeutung. In diesem Blog beleuchten wir, wie Datensicherheit in diesem Kontext gewährleistet wird.

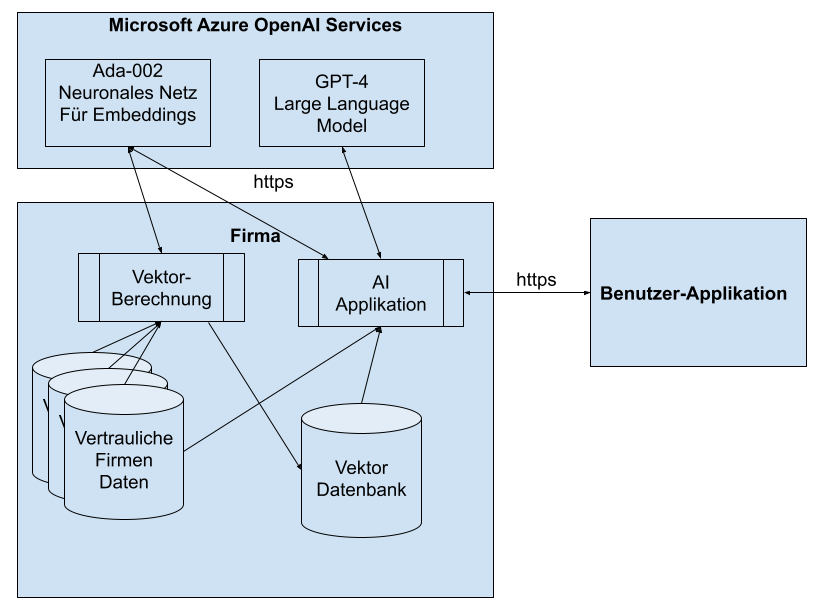

Bild 1: Datenspeicherorte und Kommunikationswege für RAG Dokumentenabfrage mit Large Language Models

Die neuronalen Netze (Modelle): Kontinuität und Sicherheit

Ein zentrales Element in der Nutzung von Azure OpenAI sind vortrainierte Modelle von OpenAI. Ein wichtiger Aspekt hierbei ist, dass diese Modelle komplett ohne proprietäre Daten der Nutzer funktionieren. Es handelt sich um statische Modelle, das bedeutet, sie lernen nicht aus den Daten der Nutzer und bleiben im Laufe der Zeit unverändert. Dieses Konzept der statischen Modelle garantiert, dass sensible Daten der Nutzer nicht in das Training des KI-Modells einfliessen. Zusätzlich werden die Modelle auf Microsoft-Servern in der Schweiz gehostet , was eine hohe Datensicherheit gemäss den Schweizer Datenschutzgesetzen bietet.

Datenhandling: Sicherheit und Lokalität

Eine wichtige Säule der Datensicherheit ist der Umgang mit Nutzerdaten bzw. mit sensiblen Firmendaten. In unserem Ansatz bleiben die Daten intern und müssen nicht als Ganzes auf die Azure-Cloud übertragen werden. Dies bietet eine zusätzliche Sicherheitsebene, da die Daten physisch im Kontrollbereich des Nutzers verbleiben.

Für die Interaktion mit dem OpenAI-Modell wird aus diesen Daten eine Vektor-Datenbank erstellt. Diese Datenbank befindet sich entweder auf den Servern des Nutzers oder auf seiner Azure-Instanz.

Interessant ist hier der Prozess des Erstellens der Vektor-Datenbank. Beim Erstellen werden die Daten einmalig an ein Embeddings-Modell gesendet, das auf Microsoft-Servern in der Schweiz läuft. Microsoft garantiert vertraglich, dass diese Daten nach dem Erstellen der Vektoren nicht gespeichert und sofort “vergessen” werden. Für besonders sensible Daten könnte für diesen Schritt alternativ ein eigenes Embeddings-Modell auf den Servern des Nutzers in Betracht gezogen werden.

Abfrageprozess: Mehrstufig und sicher

Die Benutzer-Applikation ist typischerweise eine Webapplikation oder ein Abfragefenster in einer bestehenden Applikation. Darüber gibt der Benutzer seine Frage an das System ein, welche dann über eine sichere Verbindung (https) an die AI-Applikation im Backend der Firma weitergeleitet wird. Der Abfrageprozess im Backend ist mehrstufig und gewährleistet Datensicherheit auf jeder Ebene. Zunächst wird für den Anfragetext ein Vektor über das Embeddings-Modell erstellt (auf den Microsoft-Servern oder intern). Mit diesem Vektor wird dann die interne Vektor-Datenbank abgefragt, um relevante Textschnipsel von der internen Datenablage zu erhalten.

Diese Textschnipsel, zusammen mit der Anfrage, werden anschliessend an das GPT-3.5 oder GPT-4-Modell gesendet, das zwingend auf Azure in der Schweiz laufen muss. Hier kommt die Grösse des Modells ins Spiel, da es zu gross ist, um auf eigenen Servern betrieben zu werden. Microsoft garantiert auch hier, dass die übermittelten Daten nicht für Trainingszwecke verwendet werden.

Hier gibt es allerdings noch eine wichtige Einschränkung: Microsoft behält sich das Recht vor, die Daten dieser Abfrage für maximal 30 Tage zu speichern für das sogenannte «Abuse Monitoring». Microsoft will einen «sinnvollen» Umgang mit KI fördern, und z.B. rassistische Aussagen von Modellen verhindern. Dazu gibt es automatisierte sogenante «Content Filter», welche heikle Aussagen der Modelle verhindern sollen. Diese «Content Filter» sind ebenfalls neuronale Netze, welche keine Daten speichern. Wenn aber ein «Content Filter» anschlägt und potentiell unzulässiger Inhalt detektiert wird, wird dieser Inhalt von Microsoft in einem sicheren Bereich gespeichert und kann von Microsoft Mitarbeitenden angeschaut werden, um definitiv zu entscheiden, ob eine missbräuchliche Verwendung vorliegt. Die Mitarbeitenden von Microsoft machen das unter strengen Sicherheitsvorkehrungen und die Vertraulichkeit ist gemäss Microsoft gewährleistet. Hier sehen wir aber ein kleines Restrisiko.

Dieses Restrisiko kann komplett ausgeschaltet werden, indem man bei Microsoft einen Antrag einreicht, seine Applikation von diesem Verfahren auszuschliessen. Falls der Antrag angenommen wird, kann anschliessend im Azure Portal diese Option aktiv ausgeschaltet werden und damit ist dieses Restrisiko ebenfalls beseitigt.

Fazit

Die Kombination von RAG-Applikationen und Azure OpenAI bietet immense Möglichkeiten im Bereich der KI-gesteuerten Anwendungen. Dabei steht die Datensicherheit an vorderster Front. Durch die Verwendung von vortrainierten, statischen Modellen, die keine proprietären Daten lernen, die Sicherstellung, dass Firmendaten lokal bleiben können, und einen mehrstufigen, sicheren Abfrageprozess, werden die Datenintegrität und -sicherheit in hohem Masse gewährleistet. Dieser Ansatz ermöglicht es Unternehmen, die Vorteile der KI zu nutzen, ohne Kompromisse bei der Datensicherheit eingehen zu müssen.

Falls die Daten bereits einmal in einem firmeneigenen Cloudspace wie OneDrive, Sharepont, Teams oder Email gespeichert wurden, ist die Verwendung von RAG und OpenAI APIs auf Azure mindestens gleich sicher bzw. in den meisten Fällen sogar sicherer.

Ein wichtiger Faktor ist auch, dass die Daten in jedem Fall nur verschlüsselt transportiert und somit vor Abhörattacken sicher sind.

Bei ganz heiklen Applikationen sollte hier ein Antrag auf Umgehung des Abuse Monitoring gestellt werden: https://aka.ms/oai/modifiedaccess

Quellen

Azure OpenAI Data Privacy: https://learn.microsoft.com/de-de/legal/cognitive-services/openai/data-privacy

Abuse Monitoring: https://learn.microsoft.com/en-us/azure/ai-services/openai/concepts/abuse-monitoring

Antrag für Verzicht auf Abuse Monitoring: https://aka.ms/oai/modifiedaccess

Kommentare